本次分享将主要关注OpenAI在自然语言处理领域的两个预训练的工作GPT和GPT-2.0. 通过分析GPT的两个模型,重点探讨基于单向语言模型的NLP预训练过程对序列生成任务的作用以及利用预训练模型进行NLP多种任务无监督测试的方式和效果。GPT-2.0在机器翻译、问答系统、文本摘要等复杂任务上的性能展示出NLP预训练模型的强大功能以及其在自然语言序列生成中性能。

SFFAI 24 | 罗玲:From Word Representation to BERT

本次分享主要是通过简要介绍预训练词向量研究历程(word2vec,glove,ELMo等),重点介绍BERT的主要贡献。作为刷新GLUE榜单11项NLP任务(句子关系判断,分类任务,序列标注任务等)成绩的预训练模型,BERT不仅沿袭将词向量和下游任务结合在一起实现上下文相关的优点,并且通过masked语言模型实现了真正的深度双向模型。这使得BERT不仅能更好的处理sentence-level的任务

SFFAI 22 | 古纾旸:Generative model is more than just GANs

SFFAI 23 | 李祥泰:Context modeling in semantic segmentation

SFFAI 20 | 王少楠:博士生活杂谈

SFFAI 19 | 张士峰:经验分享之我的科研历程

如何写一篇合格的NLP论文

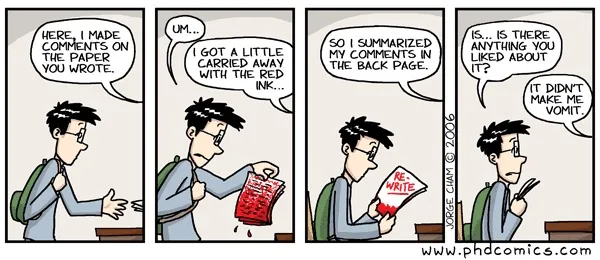

前几天刚过完ACL 2019投稿季,给不少同学的论文提供了修改建议。其中很多论文,特别是初学者的论文的问题都很相似。一想到未来还要给更多新同学重复这些话,决定索性把这些建议总结出来,不仅以后能少费一番唇舌,说不定还能帮助更多同学。于是就有了这篇短文。

本文题目取“合格”的论文,而不是优美的论文,或精彩的论文。一个原因是,我自知英文水平特别是词汇有限,从未写过自认精彩或优美的论文,并无资格提供这方面的建议。另一个原因是,下面会讲到,学术论文的关键目标并非辞藻优美而是清晰准确,我在这方面还积累了不少经验。凭借这些经验,相信“辞达已矣”不难,“言之有文”则各凭本事吧。

实际上,同组的刘洋老师对NLP学术论文写作做过非常全面而精彩的报告 [1],强烈推荐所有NLP同学都仔细阅读这份报告,相信会让你少走不少科研的弯路。而本文可以看做对这个报告的脚注或补充。

SFFAI 17 | 语音关键词检测方法综述

关注微信公众号:人工智能前沿讲习班,公众号对话框回复“白烨”获取PPT。

随着智能音箱、语音助手等应用的出现,普通人也可以像科幻场景一样使用语音与机器进行交流。语音关键词检测是实现人机语音交互的重要技术,被广泛地应用于各类智能设备、语音检索系统当中。

SFFAI 17 | 使用RNN-Transducer进行语音识别建模

关注微信公众号:人工智能前沿讲习班,公众号对话框回复“田正坤2”获取PPT。

基于联结时序分类(CTC)的声学模型不再需要对训练的音频序列和文本序列进行强制对齐,实际上已经初步具备了端到端的声学模型建模能力。但是CTC模型进行声学建模存在着两个严重的瓶颈,一是缺乏语言模型建模能力,不能整合语言模型进行联合优化,二是不能建模模型输出之间的依赖关系。RNN-Transducer针对CTC的不足,进行了改进,使得模型具有了端到端联合优化、具有语言建模能力、便于实现Online语音识别等突出的优点。

SFFAI 16 | 基于姿态的人物视频生成

关注微信公众号:人工智能前沿讲习班,公众号对话框回复“杨凌波”获取PPT。

合成特定姿态下的人物图像,并进一步让人物动起来,做出逼真,连贯的动作,是多媒体领域颇具趣味的研究方向。近年来,图像生成及图像翻译领域快速发展,为人物动作视频合成问题提供了有效的实现路径。利用骨架+纹理特征合成视频帧的研究思路,现有研究取得了一定突破,已经能够合成较为流畅的高分辨率人物动作视频,但在处理遮挡,提升动作真实性,以及特征解耦等方面还有明显改进空间。