近期,来自德国ZF(ZF Friedrichshafen AG)集团人工智能实验室的团队在ICCV2021上提出了一种用于多任务学习的新方法——MultiTask-CenterNet (MCN)。

具体信息如下:

论文地址:https://arxiv.org/ftp/arxiv/papers/2108/2108.05060.pdf

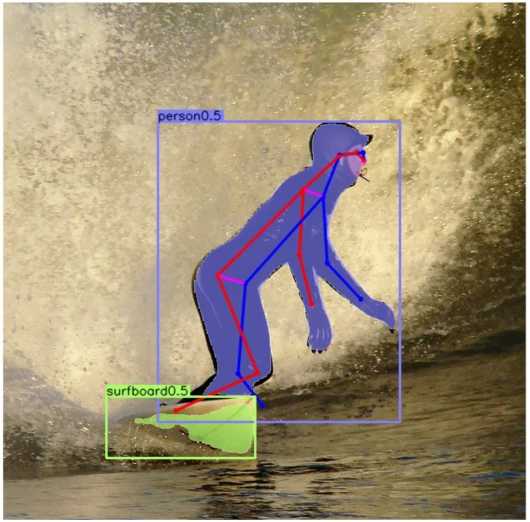

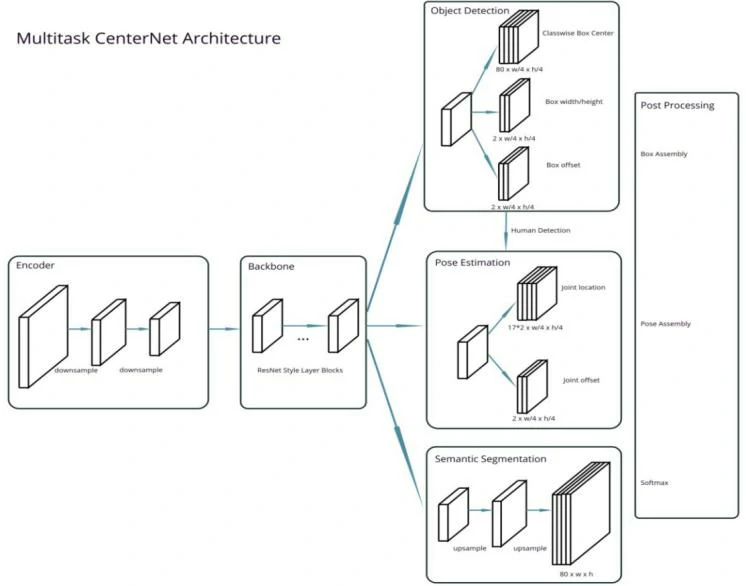

多任务学习能大大节省时间,降低内存占用,提高运行效率,但是感知相关的多任务学习网络更适用于相互之间有密切关系的多任务对象,面对各种相互关系不够紧密的学习目标,作者用一个增强了anchor-free 的CenterNet方法同时训练多个不同类型的任务,如目标检测、语义分割及人体姿态估计等。如下图所示:

研究表明,当和语义分割任务一起训练时,MCN在目标检测数据集MSCOCO(Microsoft COCO: Common Objects in Context)进行姿态估计训练比在单一模型上取得更好的效果。

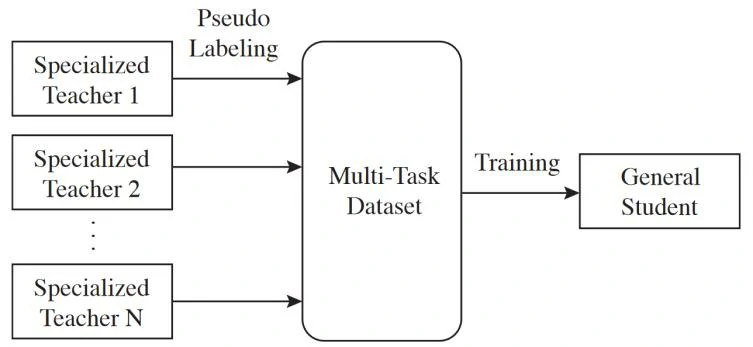

随后,Google Brain Team 也提出了一种单一通用模型——多任务自训练( multi-task self-training,MuST)模型,通过在不同数据集和任务上训练的多个相互独立的专业教师模型(如ImageNet分类模型)来训练一个多任务学生模型。

详细信息如下:

论文地址:https://arxiv.org/pdf/2108.11353.pdf

通过训练模型在多个任务上一起训练,可以学习泛化能力强的特征,增强模型的泛化能力,例如,在ImageNet上用分类任务训练的特征并不一定适用于COCO的实例分割任务,但是,从Object 365检测数据集学习的特征在很大程度上提高了COCO实例分割的性能。

然而,为同一图像数据集收集各种标注(如实例分割、关键点、图像标题)具有一定难度,并且使用标签标注图像耗时长,多任务学习能力受限。为解决这一问题,作者提出自训练的方法,使用伪标签来实现多任务特征学习。利用COCO或Object 365等数据集来训练教师模型,以在未标记的图像上生成伪标签。研究发现,一个只使用这些伪标签训练的学生模型保留了其专业教师模型的大部分迁移学习性能。因此,可以使用伪标签将特征从多个教师模型转移到单个学生模型来进行表示学习。

主要分为三步:

- 在标记的数据集上独立训练专业教师模型 。

- 专业教师模型被用来标记一个更大的未标记数据集,以创建一个多任务伪标签数据集。例如,这些教师可以在Object 365检测数据集中生成图像分类和深度估计的伪标签。

- 最后,用这些在不同数据集、任务上训练的教师模型的伪标签训练具有多任务学习的学生模型,此时,深度估计和图像分类任务可以同时进行。

论文实验包括四种教师模型:分类、语义分割、目标检测和深度估计,提供各种训练参数和伪标签。

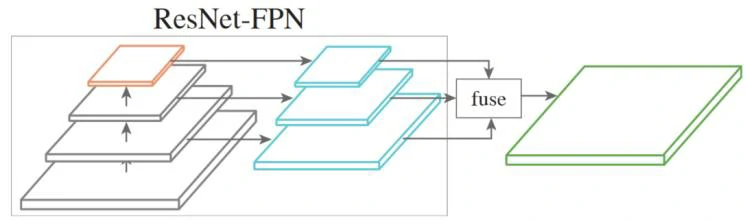

多任务学习的学生模型则是一个简单的基于ResNet和特征金字塔网络(FPN)的主干模型,如下图所示:

本文的实验表明,这种简单的模型架构能够学习共享不同任务的特征,在迁移学习任务中,多任务的学生模型性能不比专业教师模型的性能差。

参考资料

<Ghiasi G, Zoph B, Cubuk E D, et al. Multi-Task Self-Training for Learning General Representations[J]. arXiv preprint arXiv:2108.11353, 2021.>

<Heuer F, Mantowsky S, Bukhari S S, et al. MultiTask-CenterNet (MCN): Efficient and Diverse Multitask Learning using an Anchor Free Approach[J]. arXiv preprint arXiv:2108.05060, 2021. >

https://mp.weixin.qq.com/s/nhv1l9xBSaZceibIn5fhqw

https://zhuanlan.zhihu.com/p/405008318

原文链接

https://www.scholat.com/teamwork/showPostMessage.html?id=10379