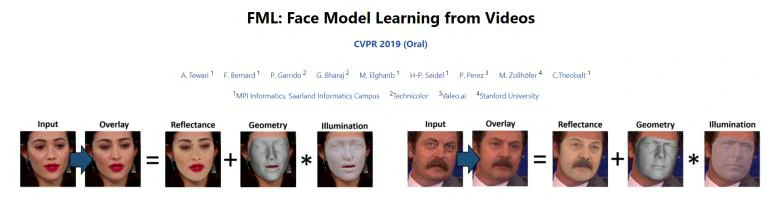

三维人脸重建就是建立人脸的三维模型,它相对于二维人脸图像多了一个维度,在电影和游戏等领域应用广泛。马克斯·普朗克计算机科学研究所与斯坦福大学的科研人员于2019年提出了一种新型的面部三维重建模型,最终得到的效果十分惊艳。该模型基于自监督学习,完全从零开始学习,使用了来自 YouTube 抓取的 6000 多个名人的视频片段进行训练;其将面部的多种特征分离再重新组合,结构化程度很高;且其能以任意帧数重建人脸面部,适用于单目和多帧重建。这项工作被CVPR2019接收,原文题目为FML: Face Model Learning from Videos。

研究背景与意义

3D 人脸建模在人脸识别、人脸表情分析、3D 动画和游戏、生物医学分析等领域有很大的发展前景同时也是一项很有挑战性的工作。由于不同人脸之间具有结构特征(人脸形状、姿态)相似性和生物特征(表情、五官、肤色等)的差异性,这种特性使得用二维方法来解决人脸相关的问题有很大的局限性。比如在人脸姿势和表情有很大变化时,同一个人的不同人脸图片也会有很大的差异,这也是人脸识别面临的最大问题。相较于 2D 人脸表达方式,3D 人脸具有人脸姿态和表情的内在不变性,而且包含了更丰富的人脸结构特性和人脸表情信息。构建高精度具有真实感的 3D 人脸模型在计算机图形学领域也是一项非常有挑战性的工作。现有构建 3D 人脸模型的方法有直接通过激光扫描设备获取 3D 点云和利用人脸的多示图、图形使用算法模型重建这两大类:

- 第一种方法: 使用 3D 激光扫描仪对人脸直接进行扫描是现有应用最广泛的 3D 人脸数据采集方法,这种方法的缺点是 3D 数据采集设备成本高,体积大,不适合进行推广。

- 第二种方法: 使用人脸图片和视频,通过构建人脸模型从图片中估计 3D 人脸参数对人脸进行重建的方法具有成本低,易于推广的优点,但是基于模型的三维重构效果和精确度受限于模型的表达能力。

基于模型的三维人脸重建是近年来很受欢迎的人脸重建方法。由于这种方法可以从一张给定的人脸图片重构出对应的三维人脸模型并且估计相应的场景光照条件,人脸重构成本低,适应性强,所以算法的应用场景很广阔。随着人脸平均模型的表达能力提升,这种三维人脸重建的方法越来越受欢迎。基于人脸图像的三维重建方法非常多,常见的包括立体匹配,Structure From Motion(简称SFM),Shape From Shading(简称SFS),3D Morphable Model (3DMM),其相关的传统方法和深度学习方法都有较多的研究。但是,这些方法需要大量(例如:数量大约为100)同一主题的面部图像,因此这就需要高质量的训练语料库。

主要内容

运用视觉数据重建面部在视觉和图形中有着广泛的应用,包括面部跟踪、情感识别以及与多媒体相关的交互式图像或视频编辑任务。因为智能设备、消费者和专业相机连续提供了几乎是无穷无尽的原始资源,这使得面部图像和视频无处不在。当这些数据在没有受控的场景位置、照明或入侵设备的情况下被捕捉到时,被一部分人称为in-the-wild 图像。通常,in-the-wild 数据分辨率低、噪声大或包含运动以及焦点模糊,这使得重建问题比在受控设置中还要难。

三维人脸重建通过 in-the-wild 单目 2D 图像和视频数据处理分离的面部形状特征[1](中性几何)、皮肤外观(或反照率)和表情,以及估计场景照明和相机参数。其中一些属性面部形状特征,例如反照率和光照。此外,场景灯光较差,深度模糊性,和由于面部头发、太阳镜和大幅头部旋转导致的阻塞使得 3D 面部重建变得复杂。

为了解决单目三维人脸重建中困难的问题,大多数现有方法依赖于强大的先验模型的可用性。尽管这些方法实现了令人印象深刻的面部形状和反照率重建,但由于其使用的面部模型而引入了固有的偏差。例如,Blanz等人提出的3DMM,3DMM基于相对较小规模的白种人演员的 3D 激光扫描[2],从而限制了泛化到一般的现实世界的身份和种族。随着基于 CNN 的深度学习的兴起,人们已经提出了除了 3D 重建之外的各种技术,还从单目图像中进行面部模型学习。然而,这些方法严重依赖于用已有的 3DMM 来解决单目重建设置的固有深度模糊。而另一个不需要类似 3DMM 的面部模型的行业,都是基于照片收集的。然而,这些方法对训练语料库都有很高的要求。

在原文中,研究者们介绍了一种方法,该方法使用从互联网视频中爬取的剪辑来学习一个全面的人脸身份模型[3]。该面部身份模型包括两个部分:一个部件表征面部特征的几何形状(modulo Expressions),另一个部件表示以反照率表示的面部外观。由于在本研究中,研究者们对训练数据的要求很低,他们的方法可以使用几乎无穷无尽的社区数据,从而获得一个具有更好泛化性的模型,而用激光扫描的同样庞大数量的一大群人来进行模型建造几乎是不可能的。与大多数以前的方法不同,该方法不需要已有的形状标识和反照率模型作为初始化,而是从零开始学习。因此,该方法适用于没有可用的现有模型的场景,或者难以从 3D 扫描创建这样的模型的情况(例如:对于婴儿的面部)。

从技术角度来看,本研究的主要贡献之一是提出了一种确保面部身份和反照率重建在同一主体的框架中是一致的新的多帧一致性损失。通过这种方式,就可以避免在许多单目方法中存在的深度模糊,并获得一个更精确和稳健的面部几何和反照率模型。此外,通过在研究者们学习的面部识别模型和现有的混合形状表达模型之间施加正交性,该方法自动地将面部表情从基于身份的几何变化中分离出来,而不需要求助于大量手工制作的先验。

具体方法

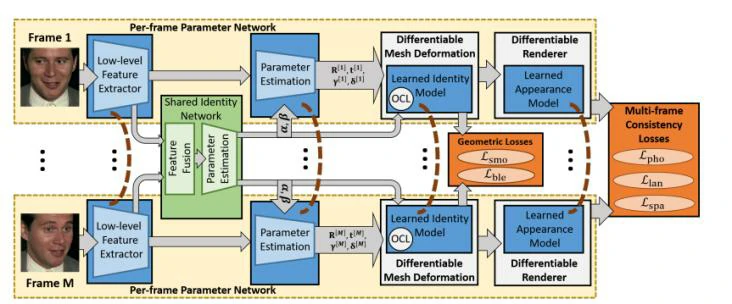

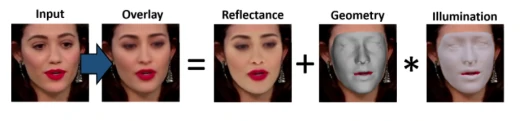

本研究的新的人脸模型学习方法解决了两个任务:即共同学习(Ⅰ)参数人脸几何和外观模型;(Ⅱ)人脸形状、表情、反照率、刚性姿态和入射光照参数的估计。该研究的方法的概述如图2所示。

基于图形的人脸表情

该研究提出了一种基于粗糙形状变形图和高分辨率的曲面网格的多级人脸表情,其中每个顶点都有一个颜色值来编码面部外观。这种表示使该研究的方法能够学习基于多帧一致性的几何和外观的人脸模型。将在下面详细解释该研究的各部分内容:

- 可学习的基于图形的标识模型:该研究没有学习在高分辨率网格上的标识模型,而考虑基于变形图像的下维参数化来简化这一任务[4]。

- 模糊形状的面部表达模型:为了捕捉面部表情,该研究使用了一个结合了来自[5]和[6]的面部表情模型的线性混合形模型。这个模型是固定的、未被学习的。因此,该表达式的变形可直接应用于高分辨率的网格中。

- 分离形状和表达式:该研究通过在学习到的形状识别基础和固定的混合形状基础之间施加正交性,从而确保了形状识别与面部表情的分离。

- 每个顶点均可承载的外观模型

可微分图像形成

为了实现端到端自监督训练,该研究采用了一种可微的图像形成模型,将三维模型空间坐标映射到二维屏幕空间坐标上,同时还应用了一个可微照明模型。将在下面解释这两种模型:

- 照相机模型:该研究假设的是在w.l.o.g中照相机的空间对应于世界空间;

- 照明模型:在远光照明以及单纯的Lambertian,表面性质的假设下,该研究采用球谐函数[7]。

多帧一致面部模型学习

该研究提出了一种用于一致的多帧面部模型学习的新颖网络。它由M个暹罗塔组成,它们同时处理不同流中的M帧多帧图像。每个塔由一个编码器组成,该编码器估计帧特定于帧的参数和识别特征图。

实验结果

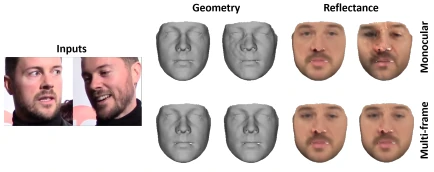

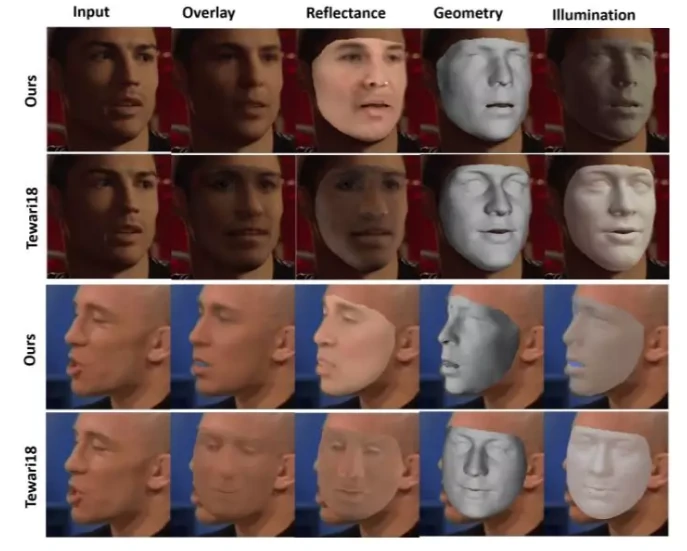

由于该研究的模型是在一个大型的多视图图像语料库上进行训练的,因此它可以很好地推广到不同的人种,即使是在存在面部毛发遮挡以及化妆的情况下。该研究在TensorFlow中实现和培训网络。该研究先训练表达式模型,然后训练全网络端到端,收敛后使用较大的反射率学习速率对网络进行微调。通过上述经验发现,该训练策略改善了对面部毛发、化妆和眼睑的捕捉,从而提高了模型的推广性。这个方法也可以应用于测试时的多帧重建。图3展示了通过单目图像来重建几何、重光和场景照明的定性结果。在此之后,进一步与单目情况相对比,选取了同时提供两幅图像的方法,这提高了所获得的三维重建的一致性和质量(通过图4所示)。

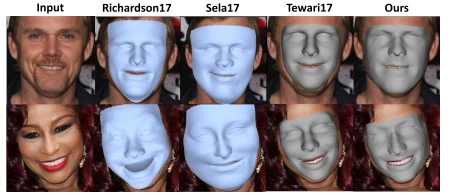

在训练过程中,由于现有的单目重建方法依赖于现有的面部模型或合成生成的数据,因此无法很好地推广到模型范围之外的面部。因此,它们无法处理面部毛发,化妆和未建模的表情,详情见图5。

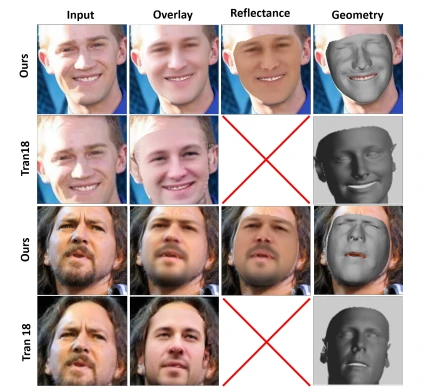

自从该研究通过 in-the-wild 训练模型后,就可以捕捉这些变化,从而在这种具有挑战性的情况下更好地概括。该研究还与 Tran 等人基于 in-the-wild 数据重新定义3DMM比较了基于细化的方法。(见图6)

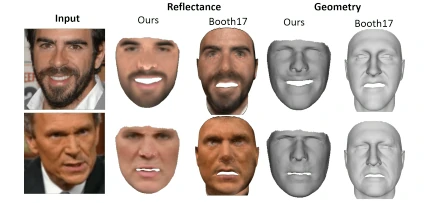

由于在单目数据学习中,上述学者的的纠正容易产生伪影,特别是当遮挡或极端头部姿势存在时。相反,该研究的方法从零开始学习一个基于多视图监督的完整模型,从而提高了鲁棒性和重建质量。同时,还与只学习了一个纹理模型进行比较(见图7),即从一个持续彩色的网格开始,从头开始学习所有的变化模式(几何形状和反射率)。相比之下,该研究的方法在不需要3DMM的情况下就产生了更好的几何形状,与其他方法相反,其甚至还将反照率和光照分离。

总结与思考

该研究提出了一种用于人脸模型和3D人脸重建网络的联合多帧学习的自监督方法。由于没有可用的实例,因此该研究的模型是根据大量的in-the-wild视频剪辑语料库从头开始学习的。虽然已经通过从 in-the-wild 数据中学习得到了令人信服的结果,且和其他方法相比较该方法已经优于最先进的学习基础上的人脸重建,但由于运用的 in-the-wild 数据通常分辨率低,噪声大或模糊,使得限制了预期想要达到的效果。

通过对实验结果分析,我发现了该研究目前存在如下情况:

- 通过观察由研究者把面部分解成了反照率、三维几何形状和光照等特征,再进行组合重建得到了如上图8所示的最终合成结果overlay ,我发现重建后得到的人脸除了没有皱纹且面部五官较为模糊以外,五官特征和面部表情都和原人基本一致,且面部阴影效果也得到了高度还原。其中,五官模糊的部位主要在眼睛部分,重建后的人脸眼睛部位相当不清晰不仅缺少了双眼皮等特征,而且整个眼睛部位浑浊无神。

- 通过观察图2发现,该研究所用方法的的网络结构很复杂,且在多处都使用深度学习。这也就说明了该方法使用的是深度神经网络,且这种深度神经网络从大型无约束图像数据集中的每个主题里面的多个图像(例如:多视图序列、单目视频)学习面部形状和外观空间。这也说明了重建面部不能很好地还原皱纹这一现象,可能是因为自监督学习过程中多帧图像面部动作的正则化作用的结果,但从另一角度来看,这也使得身份重建更加鲁棒。

- 研究者把面部分解成了反照率、三维几何形状和光照这三个特征,再进行组合重建。通过图6和图9观察知该方法和其它现有方法的相比较,从图中的效果看来,除了用该方法得到的图片的还原度不高以外,其相对于其它方法相比可以更好地分离反照率、三维几何形状和光照这些不同的特征。同时,该模型合成的各种特征都能很好地贴合面部,不受侧面视角影响。

参考链接

https://www.scholat.com/teamwork/showPostMessage.html?id=9385

[1] Zollhöfer, M., et al., State of the Art on Monocular 3D Face Reconstruction, Tracking, and Applications. Computer Graphics Forum, 2018. 37(2): p. 523-550.

[2] V., et al., Reanimating Faces in Images and Video. Computer Graphics Forum, 2003.

[3] Chung, J.S., A. Nagrani and A. Zisserman. VoxCeleb2: Deep Speaker Recognition. in Interspeech 2018.

[4] R. W. Sumner, J. Schmid, and M. Pauly. Embedded deformation for shape manipulation. In ACM Transactions on Graphics (TOG), volume 26, page 80. ACM, 2007.

[5] O. Alexander, M. Rogers, W. Lambeth, M. Chiang, and P. Debevec. The Digital Emily Project: photoreal facial modeling and animation. In ACM SIGGRAPH Courses, pages 12:1–12:15. ACM, 2009.

[6] C. Cao, Y. Weng, S. Zhou, Y. Tong, and K. Zhou. Facewarehouse: A 3D facial Expression database for visual computing. IEEE TVCG, 20(3):413–425, 2014.

[7] R. Ramamoorthi and P. Hanrahan. A signal-processing framework for inverse rendering. In Proc. SIGGRAPH, pages 117–128. ACM, 2001.

[8] E. Richardson, M. Sela, R. Or-El, and R. Kimmel. Learning detailed face reconstruction from a single image. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 2017.

[9] M. Sela, E. Richardson, and R. Kimmel. Unrestricted Facial Geometry Reconstruction Using Image-to-Image Translation. In ICCV, 2017.

[10] A. Tewari, M. Zollh¨ofer, H. Kim, P. Garrido, F. Bernard, P. Perez, and T. Christian. MoFA: Model-based Deep Convolutional Face Autoencoder for Unsupervised Monocular Reconstruction. In ICCV, 2017.

[11] J. Booth, E. Antonakos, S. Ploumpis, G. Trigeorgis, Y. Panagakis, and S. Zafeiriou. 3d face morphable models ”in-thewild”. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 2017.

[12] A. Tewari, M. Zollh¨ofer, P. Garrido, F. Bernard, H. Kim, P. P´erez, and C. Theobalt. Self-supervised multi-level face model learning for monocular reconstruction at over 250 hz. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018.