论文题目为Gradual Relation Network: Decoding Intuitive Upper Extremity Movement Imaginations Based on Few-Shot EEG Learning。此论文研究了基于小样本学习的上肢运动想象问题。本文将会对此论文进行简单介绍,最后对此论文进行总结并提出一些相关思考。

背景

脑机接口(BCI)是一种连接用户和外部设备的通信工具。在实时BCI环境中,校准程序对于每个用户和每个会话都是特别必要的。这个过程消耗了大量的时间,这阻碍了BCI系统在现实世界中的应用。为了避免这个问题,作者采用了基于度量的小样本学习方法来解码直观的上肢运动想象,使用了一个渐进的关系网络从25名受试者获得了上臂、前臂和手与直观上肢运动相关的脑电数据。离线分析下的总体平均多类分类结果在1shots、5shots和25shots设置下分别为42.57%、55.60%和80.85%。此外,作者在五名受试者者的实时饮酒任务中的解码成功率为78%,证明了在线机器人手臂控制的可行性。

本文主要的贡献

- 首次在实时MI-BCI(运动想象脑机接口)系统中采用少量学习方法

- 无论训练数据的大小如何,提出的模型都优于传统方法

方法

文章提出的方法是一种基于度量的小样本学习方法,之前主要应用在图像领域分类任务中。本团队成员叶耀光所介绍的原型网络[1]就是一个典型的基于度量的小样本学习方法,其思想是通过网络学习一个度量空间,然后计算待测样本与每个类的原型表示的距离,其中距离是通过线性距离计算公式比如欧式距离计算的。本文的度量模型是一种叫做关系网络[2]的模型,它是原型网络的改进,改进点就是在计算距离的时候,不再使用欧式距离计算,而是让网络自动学习计算距离的方式。

实验

受试者:

25名健康受试者(15名男性和10名女性,年龄20-28岁,均为右撇子)进行实验

实验数据:

通过通道选择,下采样等操作最后将数据固定为适合模型输入的形状(5,5,750),实验数据总共有三种类别(上臂、前臂、手)

实验设置:

n-way k-shot ,n-way 代表小样本问题中要分类的类别数,文中是三类,k-shot表示每类取k个样本。(本文k=3,way=1、5、25.)

模型框架GRN(Gradual Relation Network):

GRN由一个编码器和一个关系模块组成,编码器用来将样本映射到一个统一的向量空间,这种编码器的主要特点是保持频率信息和降维。关系模块收集相关的频谱信息,并将其与原型特征进行比较。通过逐组比较编码特征,该模型可以更精确地积累相关的频率和时间信息。下面具体介绍编码器和关系模块:

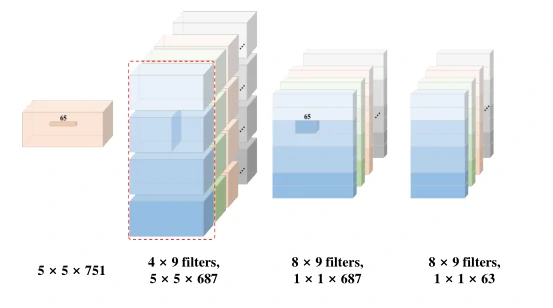

编码器:

编码器需要把样本映射到一个统一的向量空间同时需要保持频率信息和降维,作者参照了EEGnet[3]结构,来设计编码器,EEGnet是一种紧凑型可分离的卷积神经网络模型,被证明在三种典型的BCI范式:P300电位、稳态视觉相关电位(SSVEP)和 事件相关电位(ERP)中,该算法的解码性能与传统方法相当。编码器如图1

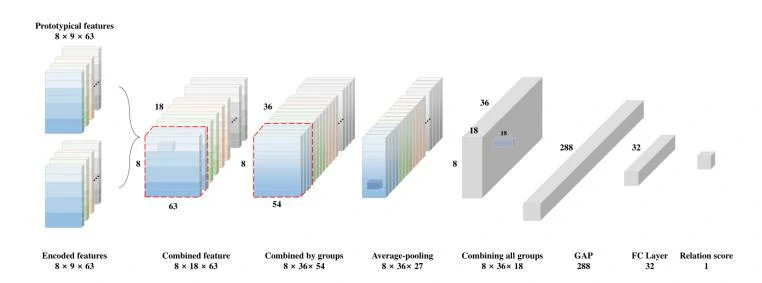

关系模块:

关系模块需要计算编码特征和k类(K=0,1,2)原型特征之间的关系得分。具体做法是经过编码器输出得到特征向量,通过两个FC层和sigmoid函数来提取两个编码特征之间的关系得分,最后通过softmax输出得分矩阵,得分矩阵最大值位置成为未知脑电信号的预测,如图2。

实验结果和分析:

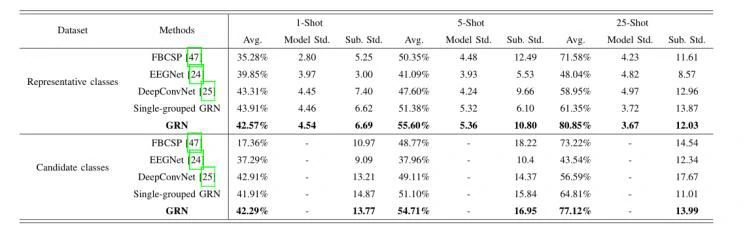

作者比较了1、5、25shot 设置下不同模型的实验结果,所提出的GRN方法在不同shot设置下都优于深度学习和FBCSP,且参数量比深度学习模型少。如表1。

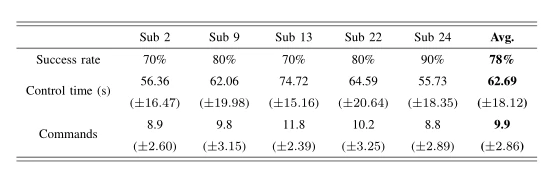

作者还进行了系统在线机械臂控制的实验,通过让受试者执行十个运动想象饮水任务,得出用户控制机械臂的成功率。五名受试者的平均成功率为78.00%。表2。

总结和思考

- 基于度量的小样本学习可以有效较少脑机接口系统的校准时间

- 本文提出的模型无论在线实验和离线实验的解码能力都表现良好

思考本文可能的改进点:

- 该模型的编码器可以采用图卷积结构,因为脑电信号是结构化数据,图结构可能可以更好地提取脑电通道之间的信息。从而更好地提取脑电特征

- 引入注意力机制,由于不同的行为可能引起特定通道位置不同的电位,所以在通道引入注意力机制可能有所提升

- 使用基于优化的元学习,比如MAML算法对模型进行优化

参考链接

https://www.scholat.com/teamwork/showPostMessage.html?id=9915

[1] J. Shell, K. Swersky, and R. Zemel, “Prototypical networks for few-shot learning,” in Proc. Adv. Neural Inf. Process. Syst. (NIPS), 2017,pp. 4077–4087.

[2] F. Sung, Y . Yang, L. Zhang, T. Xiang, P . H. Torr, and T. M. Hospedales,“Learning to compare: Relation network for few-shot learning,” in Proc.IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), June 2018.

[3] V . J. Lawhern, A. J. Solon, N. R. Waytowich, S. M. Gordon, and C. P .Hung, “EEGNet: A compact convolutional neural network for EEG-based brain-computer interfaces,” J. Neural Eng., vol. 15, no. 5, p.056013, 2018.

本文的链接:2005.02602v1.pdf (arxiv.org)

原型网络介绍:https://www.scholat.com/teamwork/showPostMessage.html?id=9855&teamId=1158