本篇学习报告的内容为:基于时间卷积神经网络和新数据增强技术的原始单通道脑电图睡眠阶段自动分类,所参考的文献是《Automatic Sleep Stage Classification Using Temporal Convolutional Neural Network and New Data Augmentation Technique from Raw Single-Channel EEG》,该文献发布时间为2021年。文献在使用EEG单通道的情况下所采用的方法是:利用卷积神经网(CNN)络提取特征向量,随后使用时间卷积神经网络(TCNN:temporal convolution neural network)提取特征中的时间特征向量。最后用条件随机域层提升模型性能。同时利用新的数据强化技术增强CNNs训练(用于辅助)。

简介

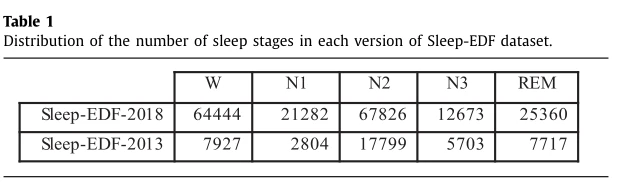

本文使用AASM评分标准,在处理脑电信号EEG特征提取阶段,不同于传统的方式:将特征分为时域特征、频域特征、时频域特征和非线性特征。本文采用的是用利用卷积神经网络进行特征提取。在单和多通道之间,考虑到多通道在实际应用中的不便,本文选择了单通道进行实验。使用的数据集为两个公共数据集Sleep-EDF-2018和Sleep-EDF-2013,每个数据集使用Fpz-Cz和Pz-Oz通道,表一为数据集具体信息。

实验方法

实验数据预处理

为减少脑电信号中的残余伪影,采用截断频率分别为0.2和35Hz的5阶Butterworth滤波器对每个脑电信号周期进行数字滤波。然后根据整个受试者信号的零均值和单位方差对历元进行归一化。

表现学习框架介绍

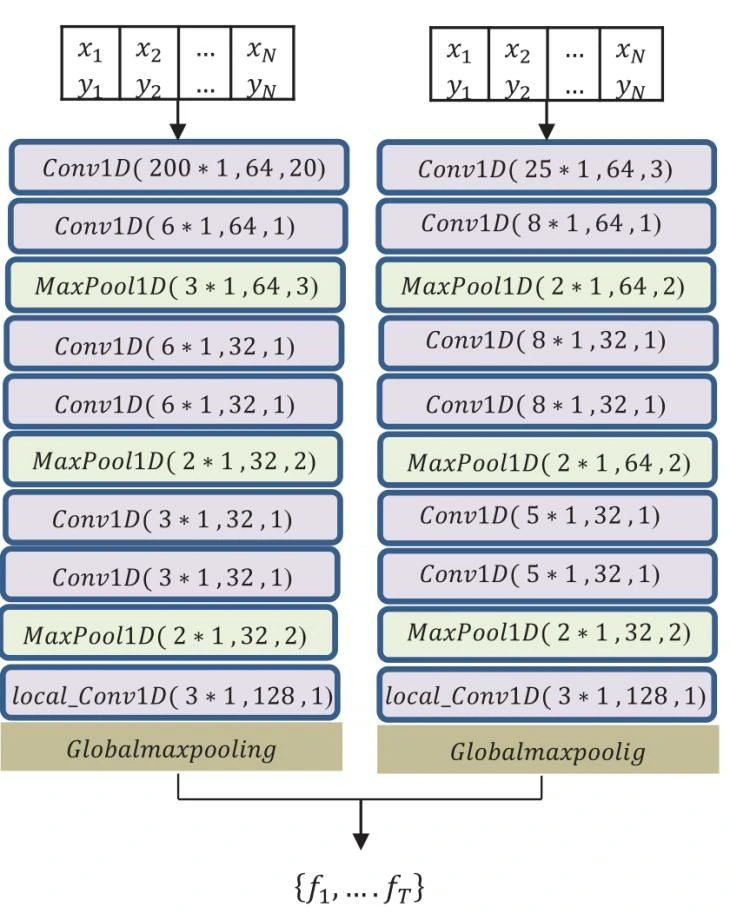

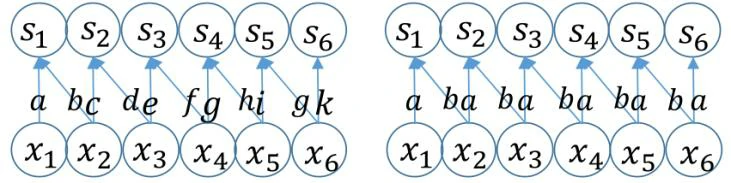

表现学习可以参考文献[1]中的表现学习的基本框架,他们的共同点是都采用了两个卷积神经网络的输入来进行EEG信号特征提取。本文两个通道分别处理不同的EEG内容,框架使用了两个不同核大小的平行一维卷积神经网络,小核提取时间信息,大核提取频率信息。池化层作用:提供向下采样特征图方法,最后的全局最大池化层的作用就是合并两个特征为一个丰富的特征进行输出。卷积层:最后一个卷积层为本地卷积,不同于其他普通卷积,它可以识别不同特征类型。如图2,局部连接层与普通卷积层比较,变量a, b, c…权重,每条边都有一个特殊的字母来表示每条边都有它的权值参数。(右)核宽为2的卷积层在整个输入中重复使用相同的两个权值。因此本地卷积相比于普通卷积的优势为其特征映射中的每个位置都学习能一套不同的过滤器。

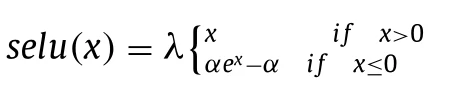

最后,将两个并行的净输出集合到一个特征向量中,用{f1,…f T}。由于使用了非常深入的架构,网络很容易受到渐变消失的影响。本文根据[2]引入了比例指数线性单元(SELU)方法来解决这一问题。SELU激活的计算方法如下:

其中 x 代表输入,α,λ找到一个不动点来正确初始化连续两层之间的输入的均值和方差。

时间卷积神经网络(TCNN)

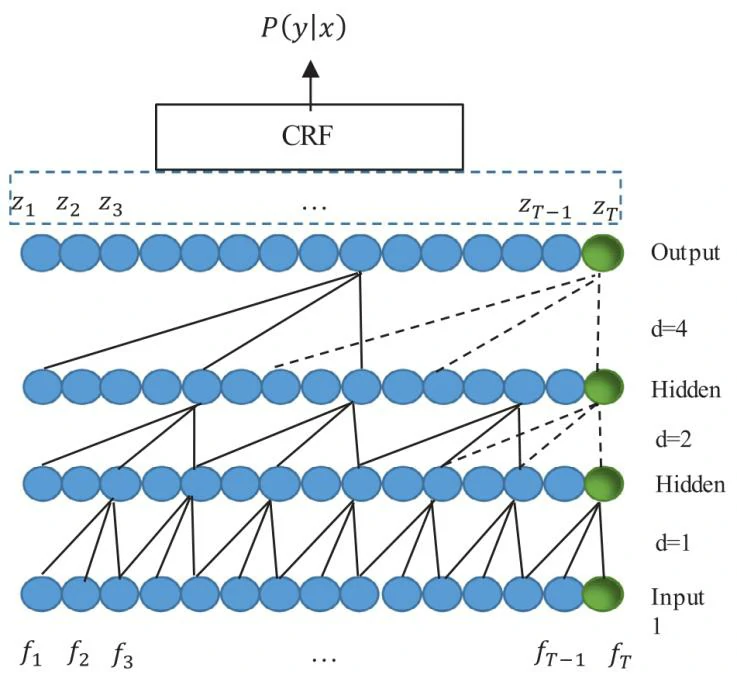

时间卷积神经网络的作用:利用表示学习允许从原始脑电图信号中提取高阶时不变模式。然后将表示学习部分提取的特征输入到TCNN中学习过滤器,并识别阶段过渡规则等时间信息到模型中。

特性:TCNN可以以提供一些简单和长记忆的最佳实践(即网络的能力[3][4],以预测遥远的未来)与卷积架构兼容的循环架构,如序列建模任务的长短期记忆。

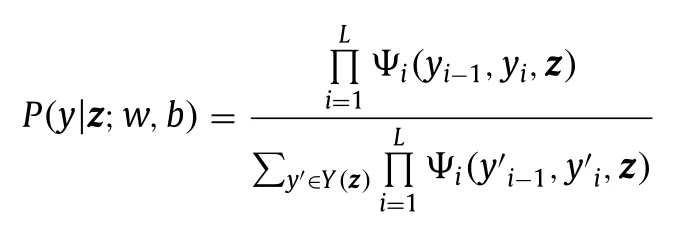

在我们提出的模型中,我们引入的两个并行CNN块从原始脑电图信号中提取特征。然后,结合TCNN和条件随机场(Conditional Random Field, CRF)应用于时间维表示的低层特征向量,生成概率评分。如图三条件随机场域(CRF)生成概率评分的公式为:

其中Z为TCNN网络的预测输出,y为实际输出。

优化方法

数据增强

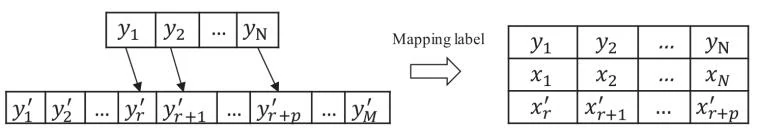

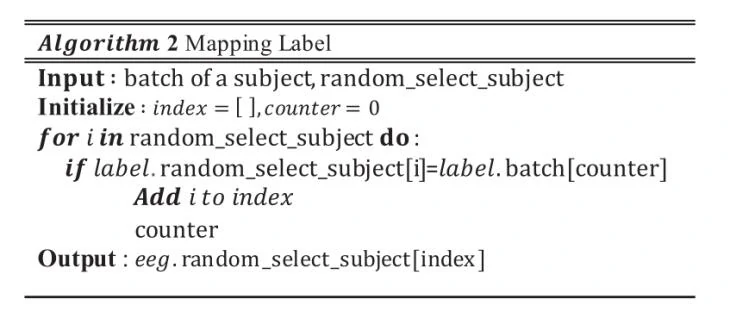

为了避免在表现学习层出现过拟合现象并增强输入数据特征情况,本文引入了标签映射(Mapping Label)方法:它是在训练集中针对第一个输入对象找到另一对象所有epoch中具有等价标签一种方法,如图四。

具体作用在表现学习的输入层,其中一个输入随机对象的一个epoch另一个输入是在除在第一个对象外的随机对象中找到相应的标签进行输入。

随机梯度下降(Stochastic gradient descent (SGD))

该方法通过向负梯度方向移动并对其参数进行迭代更新来计算模型的参数。采用了AMSGrad算法,它是最近被提出的ADAM算法的一个新变种,以最小化目标函数。

实验过程

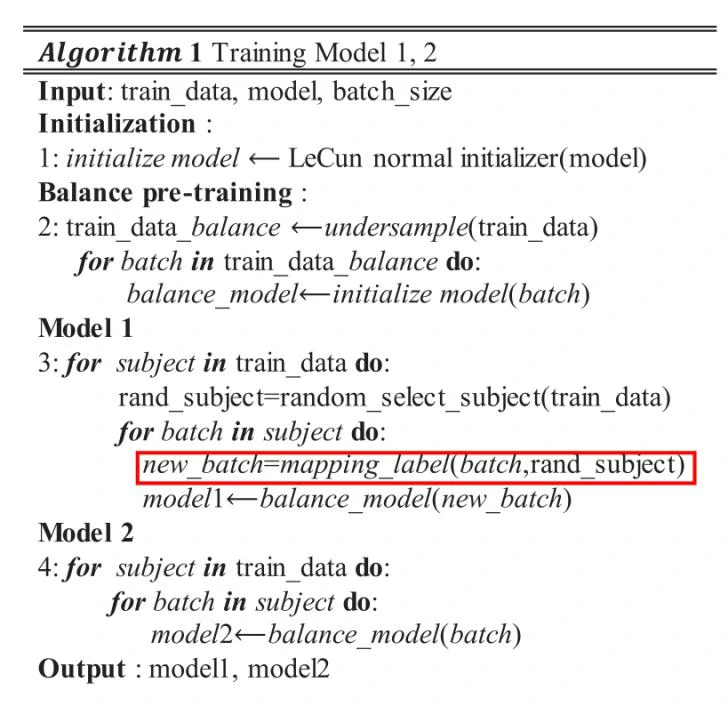

初始化

初始化方法发现了初始权值的有用分布。该分布的方差通过考虑输入层的数量来适应激活函数。该方法的结果有两个方面的成果,一是梯度值足以继续训练,二是权值先学习简单部分,然后学习复杂部分。

模型训练和预测

模型由两部分组成。首先,RL切片从原始脑电图中提取特征(见图一)。第二,TCNN+CRF(见图三),经过训练可以识别阶段过渡等时间信息。由算法1可以看出,建立该模型需要四个步骤;我们在第一步使用LeCun初始化器,然后我们从训练数据中收集平衡集,使所有睡眠阶段在少数睡眠阶段具有相同的睡眠阶段,以便重新训练模型。我们考虑平衡训练前模型的目的是防止模型对大多数类别的偏倚,并帮助网络的权值从不太可能发散的值开始。作为发现,如果没有步骤1,2,我们的模型就不能收敛。在步骤3,4中,我们通过转换前模型的权值来开始使用这些初始化权值来创建具有相同架构的两个模型。在培训过程中,模型1首先,一批睡眠阶段从序列样品一个主题应该被选中,然后其枚alent样本在另一个选定的主题应该发现,澄清的部分d这两个批次应该输入模型的输入。对于训练模型2,本文将两批相同的睡眠阶段序列输入到模型输入中。

在前两个步骤中,我们创建了一个训练前模型,帮助网络的权重从不太可能偏离的值开始。在第三步和第四步中,我们用睡眠阶段的序列样本训练了两个模型,其中一个模型采用了新的数据增强方法。

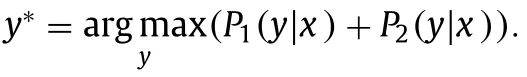

为了创建模型并进行预测:用相同的结构训练了两个模型。为了实现映射标签 第一个模型用了两个对象进行迭代:选择其中一个对象的睡眠批次EEG进入其中一个输入,应用Mapping Label 在另一个EEG信号中寻找具有相同标签的 epoch在另一个输入通道进行输入。第二个模型就是选用来自相同对象的两个相同的epoch进行输入两个通道。然后在这两个模型上使用平均集合进行预测。预测方法:

每个EEG信号纪元x的预测标签y∗是使Model1和Model2 p1 (y | x), p2 (y | x)的乘积概率总和最大化的标签。

实验结果

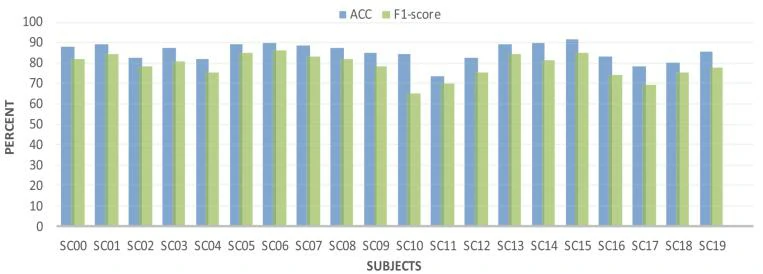

图七展示了使用数据集(Sleep-EDF-2013)20倍交叉验证的每个受试者的性能指标。可见,S15患者的ACC指标最高,平均F-score = 85%,平均ACC = 92%, S1 1最低,平均F-score = 70%,平均ACC = 74%。在数据集(Sleep-EDF-2018)上,本文结果高于其他方法的相应指标。总体上改进了性能,我们的方法通过单通道脑电图在ASSC中取得了最先进的结果。

个人总结

文献在使用EEG单通道的情况下所采用的方法是:利用卷积神经网(CNN)络提取特征向量,随后使用时间卷积神经网络(TCNN:temporal convolution neural network)提取特征中的时间特征向量。最后用条件随机域层提升模型性能。同时利用新的数据强化技术增强CNNs训练。结果表明: TCNN可以与RNN(递归神经网络)相比较,通过与CRF相结合,通过响应过渡特征,可以提高单通道EEG对ASSC的结果。

参考链接

https://www.scholat.com/teamwork/showPostMessage.html?id=10607

[1] A. Supratak , H. Dong , C. Wu , Y. Guo , Deepsleepnet: A model for automatic sleep stage scoring based on raw single-channel eeg, IEEE Transactions on Neural Systems and Rehabilitation Engineering 25 (1 1) (2017) 1998–2008.

[2] G. Klambauer , T. Unterthiner , A. Mayr , S. Hochreiter , Self-normalizing neural networks, in: Advances in neural information processing systems, 2017, pp. 971–980.

[3] A.v.d. Oord , S. Dieleman , H. Zen , K. Simonyan , O. Vinyals , A. Graves , N. Kalchbrenner , A. Senior , K. Kavukcuoglu , Wavenet: A generative model for raw audio, arXiv preprint arXiv:1609.03499 (2016).

[4] Y.N. Dauphin , A. Fan , M. Auli , D. Grangier , Language modeling with gated convolutional networks, in: Proceedings of the 34th International Conference on Machine Learning-Volume 70, JMLR. org, 2017, pp. 933–941.